一、分析

地址规律:

https://www.kugou.com/yy/rank/home/1-8888.html

https://www.kugou.com/yy/rank/home/2-8888.html

https://www.kugou.com/yy/rank/home/3-8888.html

规律:相差的只有1-2-3,榜单从1-66

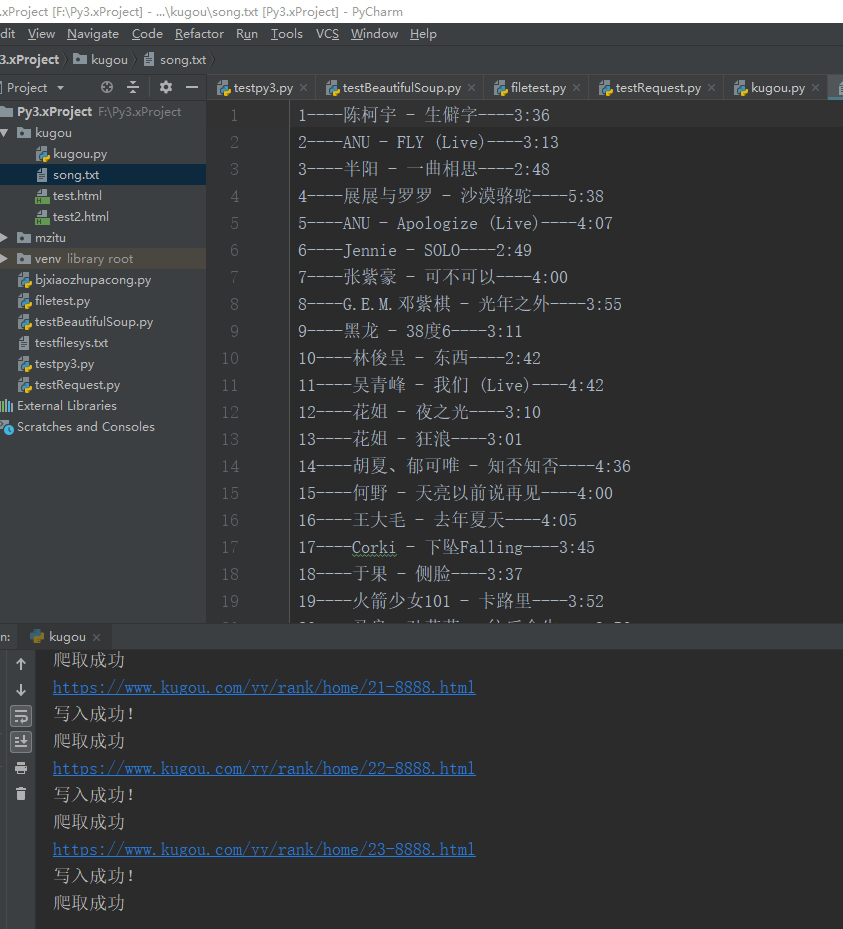

二、需要爬取的信息

1、排名

2、歌名

3、时长

三、爬取策略

1、先将第一页的源码下载下来,生成测试文件

2、获取测试文件的各项元素,能够准确提取网页中的元素,得到的数据写入文件中

2-1 提取元素,确定函数

2-2 写入数据

3、生成爬取的页面URL数组

4、联网爬取,设置时间间隔为2+RANDOM(),避免被禁

5、爬取完成

四、代码文件

1 | # encoding=utf-8 |

爬取结果:

收获:

- 1、关于编码问题 写入文件的时候请使用open(xxx,x,encoding=’utf-8’)这样写入的时候才不会出现错误